Questo articolo è pensato per tutti coloro che vogliono avere un panorama di massima dell’Intelligenza Artificiale (AI),

delle sue direzioni di sviluppo e dei suoi reali o presunti rischi e aspetti etici. Contiene

semplificazioni che faciliteranno i lettori nella comprensione delle sue nozioni fondamentali.

Qualche specialista storcerà il naso. Pazienza.

Mentre qui da noi si discetta di salario minimo e tasse non pagate, di aiuti alle imprese e di rifinanziamento della sanità, il mondo che conta sta dirottando buona parte dei propri sforzi finanziari e industriali sull’intelligenza artificiale, perché da questa branca della ricerca tecnologica ci si aspetta un enorme salto di capacità e di potenzialità economiche e commerciali, fino a ipotizzare una nuova età dell’oro. Se non altro, nel mercato delle “blue chips”, al cui vertice ci sono proprio i colossi digitali.

In una recente intervista rilasciata al “Financial Times”, Denis Hassabis ha dichiarato: "Penso che stiamo solo grattando la superficie di ciò che credo sarà possibile nei prossimi dieci anni. Siamo forse all'inizio di una nuova era d'oro della scoperta scientifica, un nuovo Rinascimento".

Secondo gli analisti di mercato della CB Insights, l'anno scorso i principali gruppi di venture capital hanno investito 42,5 miliardi di dollari solo per finanziare 2.500 start-up di AI. Poi ci sono gli investimenti nelle “magnifiche sette”, come Microsoft, Ibm, nVidia, Alphabet, Google e altre.

Hassabis ha continuato: “La migliore dimostrazione di come l'AI possa accelerare la ricerca scientifica è il modello AlphaFold di DeepMind, rilasciato nel 2021”.

DeepMind è una società fondata a Londra nel 2010 dallo stesso Hassabis e da altri due colleghi, con la missione di raggiungere una "intelligenza artificiale generale" (AGI) che eguagli tutte le capacità cognitive umane. Alcuni ricercatori hanno suggerito che l'intelligenza artificiale generale potrebbe essere ancora lontana decenni, se mai fosse raggiungibile. AlphaFold è invece una AI progettata da DeepMind per predire la struttura tridimensionale delle proteine. Nel 2022 vengono pubblicate grazie a questo programma le strutture tridimensionali di oltre 200 milioni di proteine.

E allora approfondiamo l’argomento e vediamo dove stanno andando le strade della ricerca sull'AI, se nella direzione giusta o se — a nostro modesto giudizio — stanno puntando a obbiettivi irragiungibili o inutili. O semplicemente commerciali.

E dove ci si prospetti un problema etico.

L’AI che sta avendo oggi successo, quella di cui tutti parlano al singolare, sbagliando, è quella cosiddetta “generativa”. Teoricamente, viene suddivisa in tre grandi categorie: l’ANI (Artificial Narrow Intelligence), l’AGI (Artificial General Intelligence) e l’ASI (Artificial Super Intelligence). Poi esistono intelligenze artificiali di natura diversa, che costituiscono la parte nascosta o non abbastanza esplorata da queste discipline, per una sorta di peccato originale che vedremo fra poco.

L’ANI, o AI debole, è attualmente l’unica intelligenza artificiale davvero funzionante nel mercato, ed è dedicata a compiti specifici e parziali. Non solo: occorre anche graduare la sua presenza effettiva nei software specifici, da una presenza molto limitata fino a un uso esteso di algoritmi di AI nei software utilizzati. Ovviamente, tutti i venditori tendono a dichiarare che i loro prodotti “contengono AI” (senza ulteriori specificazioni), ma bisogna vedere appunto in che misura, e in quale graduazione.

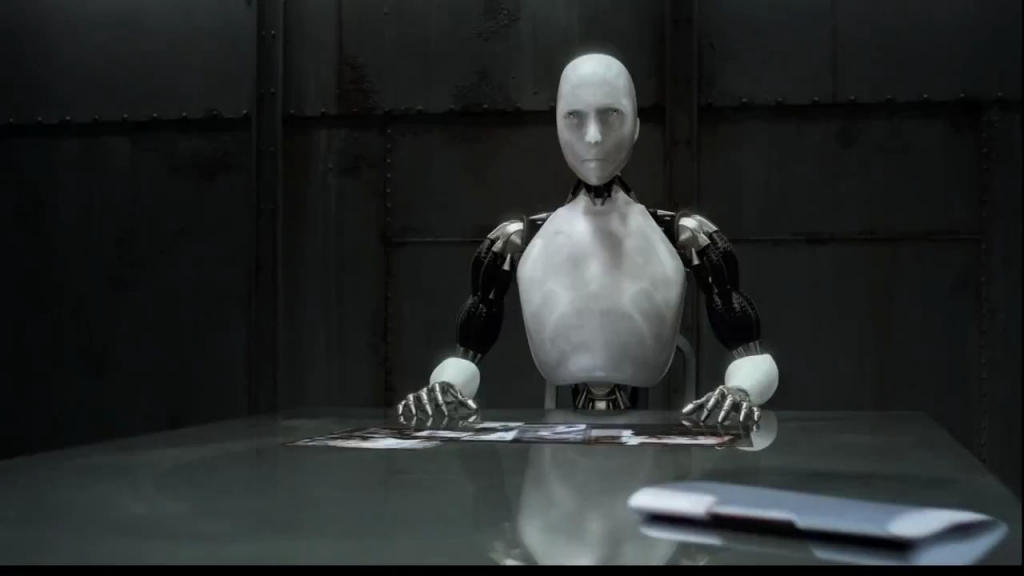

L’AGI, cioè una AI generalista in grado di comprendere, dedurre e funzionare in modo molto simile al cervello umano, è invece l’obbiettivo per raggiungere il quale si stanno moltiplicando gli investimenti fino a diventare davvero colossali. È un po’ il sacro Graal: tutti vorrebbero possedere una intelligenza artificale "generalista", in grado di svolgere compiti di assistenza e di supporto a tutte le attività umane. Ad esempio, incorporandola in robot intelligenti, magari dalle sembianze umanoidi.

Quando uno dei fondatori di DeepMind (oggi di proprietà di Google) come Hassabis dichiara che forse nel prossimo decennio si potrebbe raggiungere l’AGI, anche se non ci scommette sopra e se non sa se ci riusciremo mai, indica un obbiettivo che può mobilitare e far affluire risorse ingentissime. Si sta parlando di miliardi di dollari, ma è ancora una scommessa che non sappiamo se sia possibile.

Infine, la super intelligenza artificiale è l’ultima e finale speranza: dare vita cioè ad una entità le cui capacità in tutti i campi dello scibile siano nettamente superiori a quelle di un essere umano, e tali da farlo passare in secondo piano fra gli esseri "intelligenti" del creato.

Sia l’AGI che l’ASI pongono evidentemente un problema morale ed etico, che le grandi corporate digitali non sembrano minimamente pronte ad affrontare. Se volete, pongono anche un problema di natura religiosa.

Infatti, coloro che sono meno addentro a queste questioni elevate ritengono che la scienza e la fede operino in due direzioni opposte, e che la fede non faccia parte della scienza, così come la scienza non serva alla fede.

In realtà, come ha mostrato il bel film “Contact”, la scienza ha bisogno di una fede positiva nelle sue capacità e nelle sue conquiste, fede che non ha una base razionale, ma molte parentele con la fede religiosa.

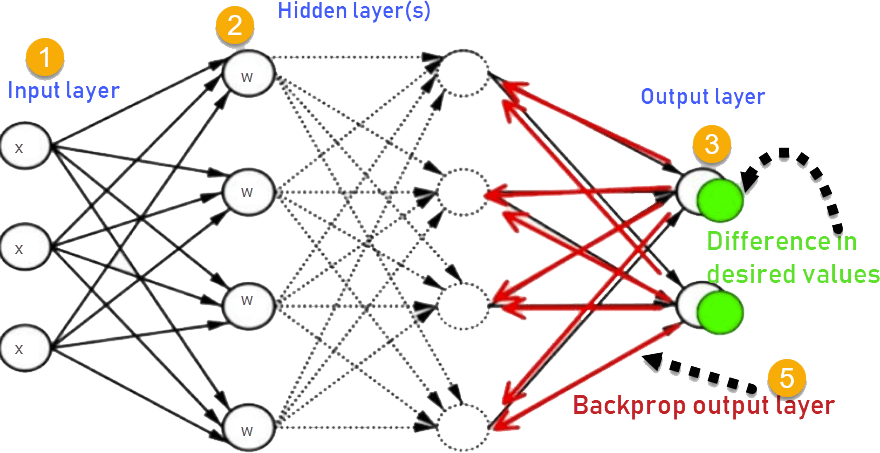

Gli algoritmi di intelligenza artificiale generativa lavorano su grandissime moli di dati e su base statistica. Sono progettati per fare a meno dell’essere umano, per autoapprendere e per migliorarsi continuamente, facendo tesoro dei propri errori. Ogni tanto vengono registrati e rimessi a punto, estraendoli dai loro ambienti, per poi essere reinseriti e tornare a fare il loro lavoro intenso di comprensione automatica statistica. Gli algoritmi di stratificazione profonda e di retro-propagazione delle correzioni degli errori (backpropagation) ne sono il cardine, per così dire.

Durante l'apprendimento, il cervello umano modifica le sinapsi per migliorare il comportamento. Nella corteccia cerebrale, le sinapsi sono inserite in reti multistrato, il che rende difficile determinare l'effetto di una singola modifica sinaptica sul comportamento del sistema complessivo. L'algoritmo di retropropagazione risolve questo problema nelle reti neurali artificiali profonde, ma storicamente è stato considerato biologicamente problematico. I recenti sviluppi nelle neuroscienze e i successi delle reti neurali artificiali hanno rinvigorito l'interesse sulla possibilità che la retropropagazione offra spunti per comprendere l'apprendimento nella corteccia. L'algoritmo di retropropagazione apprende rapidamente calcolando gli aggiornamenti sinaptici, utilizzando connessioni di feedback per acquisire segnali di errore e per correggere i propri giudizi, contenuti nelle "pesature" che vendono date agli eventi. Sebbene le connessioni di feedback siano onnipresenti nella corteccia, è difficile capire come possano fornire i segnali di errore richiesti dalle formulazioni rigorose della retropropagazione.

Vi faccio un esempio pratico. Anni fa ho impiegato un algoritmo di AI che analizzava le pose umane di alcuni atleti, specificamente di due boxeur che combattevano sul ring, per identificare le loro posture centoventi volte al secondo. Il compito di questa AI era di muovere due avatar corrispondenti, che riproducevano fedelmente i due pugili, esattamente come si muovevano i veri atleti sulla scena, cercando di farlo in tempo “quasi immediato” (tecnicamente si dice “near real time”). Lo scostamente dalla realtà era, nel nostro test, inferiore al mezzo secondo.

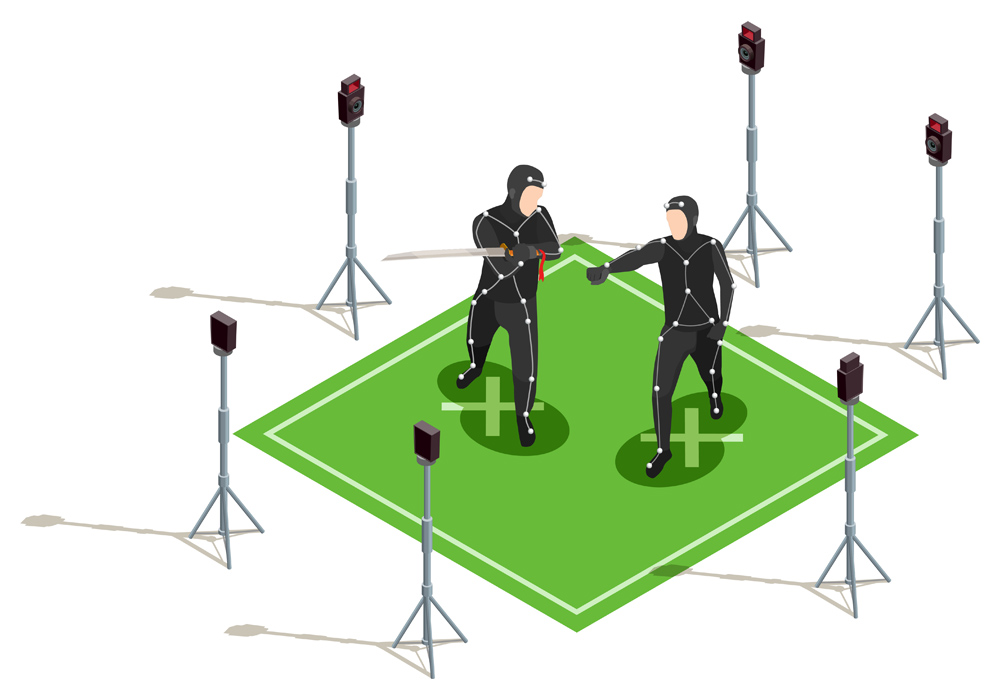

Normalmente, i movimenti degli atleti (o degli attori su un set cinematografico) vengono catturati in modo diverso: gli si fa indossare una tuta coperta da sensori, posizionati principalmente sugli snodi dello scheletro umano, e poi si rilevano questi sensori mediante dei rifrattori di infrarosso o di microonde.

I movimenti poi vengono passati dal sistema di cattura dei movimenti (“motion capture”) agli scheletri degli avatar da muovere ("retargeting"), e così nei videogiochi (o nei film) si vedono gli attori digitali muoversi fluidamente come se fossero persone vere. L'occhio del giocatore (o dello spettatore) viene ingannato facilmente, anche solo muovendo i 23 nodi principali di articolazione dello scheletro.

Nel nostro caso, l’AI (messa a punto dal Max Plank Institute di Saarbrücken) doveva invece "vedere" attraverso delle telecamere poste intorno alla scena, e "comprendere" il movimento degli atleti sul ring, per “aggiustare” la posizione delle membra degli avatar corrispondenti facendole coincidere con quelle degli attori umani. In questo modo i due pugili potevano salire sul ring senza alcun sensore addosso, niente tute o diavolerie, ma con la loro sola tenuta tradizionale fatta di canottiera e calzoncini, e combattere normalmente (senza simulare).

Il sistema poteva quindi essere usato dal vero per tutti i combattimenti reali, senza infrangere le regole ferree di questo (come di altri) sport, che vietano ai loro atleti di indossare alcunché che non sia previsto nei loro disciplinari.

Questa tecnica di “retargeting evoluto”, secondo le nostre intenzioni, consentirebbe di trasformare le normali televisioni domestiche che tutti abbiamo in sala da pranzo, in finestre tridimensionali interattive dove il pubblico dei telespettatori potrebbe divertirsi a "vagare" o "volare" nello spazio tridimensionale di eventi sportivi (o di concerti, o di manifestazioni in diretta) riprodotti in tempo reale negli schermi domestici. Il telespettatore potrebbe cioè muoversi liberamente con il proprio telecomando all'interno di uno scenario realistico, mentre è in corso la manifestazione, e posizionarsi dove meglio crede, ad esempio scendendo in campo (virtualmente) insieme ai calciatori della propria squadra, e assistendo al match come se stesse giocando insieme a loro.

Il problema dell’AI che stavamo utilizzando consisteva in alcuni errori di posizionamento degli arti, che nel corpo umano hanno vincoli meccanici molto stretti. Ad esempio, un braccio può ruotare all’indietro ma solo fino ad una certo punto, oltre il quale non può andare, pena la rottura dei legamenti interni e perfino delle ossa. Così come accade per le gambe. L’AI non aveva queste limitazioni, gli avatar possono far girare gli arti come vogliono. Quindi ogni tanto — soprattutto nei momenti di sovrapposizione fra i due atleti, quando qualche camera veniva occlusa e mancavano dati di calcolo — la posizione degli arti risultava del tutto innaturale.

Una volta inseriti e registrati i vincoli, l’AI ha proceduto speditamente a propagare le correzioni, comprendendo meglio la cinematica umana, e continuando secondo per secondo a retro-propagare queste correzioni, apprendendo sempre meglio i nostri movimenti. Il test ha avuto successo.

Allo stesso modo, i Grandi Modelli Linguistici (LLM, large language model) ogni tanto prendono degli abbagli.

La scorsa settimana i ricercatori di DeepMind hanno pubblicato un documento che illustra una nuova metodologia, chiamata SAFE, per ridurre gli errori di fatto, noti come "allucinazioni", generati da modelli linguistici di grandi dimensioni come GPT di OpenAI e Gemini di Google. L'inaffidabilità di questi modelli in alcune situazioni critiche ha portato molti avvocati a presentare loro domande maliziose con citazioni fittizie per dimostrarne proprio le falle, e ha scoraggiato molte aziende dall'utilizzarli a livello commerciale.

Una AI che commette errori cruciali ci pone meno problemi di una AI che non ne commette alcuno. Quando sentiamo parlare di Intelligenza Artificiale, infatti, la nostra prima reazione è sempre la stessa: “Ma sarà più intelligente di me?”

Questo tarlo scava poi nel profondo, ingenerando timori e terrori sul fatto che la società umana possa finire nelle mani di intelligenze artificiali non empatiche, in grado di condizionarci senza avere nessun principio etico, morale, religioso o anche semplicemente simpatetico con la razza umana. Un rischio di cui faremmo volentieri a meno. No?

Ma non è così, queste sono solo paure irrazionali, da cavernicoli. Sovente anche indotte da una letteratura fantascientifica che ha soffiato sul fuoco di questi timori, e che non vede l’ora di terrorizzare lettori e spettatori.

Come ha chiarito bene in un’altra recente intervista uno dei padri degli algoritmi di backpropagation, Geoffrey Hinton, le AI sono guidate sempre dagli esseri umani. Non agiscono mai da sole e in modo autonomo e indipendente. Se chi guida questi processi è, come dice Hinton, un “bad actor”, una persona malvagia, allora il risultato sarà sfavorevole, molto sfavorevole o straordinariamente sfavorevole all’umanità che ne subisce le conseguenze e le sue applicazioni, a seconda dell’intensità della presenza di questi algoritmi nelle procedure applicate.

Ma l’AI non ha nessuna colpa. La colpa è sempre di chi decide, dei "bad actors", dei loro interessi e di quelli di tutti coloro che gli stanno dietro. Per questo una considerazione democratica è l'unica forma di difesa non fantascientifica per chi non vuole diventare schiavo di un robot domestico fuori controllo.

Faccio un esempio: con il livello di capacità di calcolo e di controllo che abbiamo raggiunto con queste AI generative, ci vorrebbe non più di mezz’ora, forse molto meno, a scovare, identificare e sanzionare tutti i 10 milioni di infedeli fiscali italiani stimati recentemente dall'Agenzia delle Entrate. Con analisi approfondite, portate fino al centesimo, delle loro evasioni o elusioni. Perché allora non viene fatto? Semplice, perché altrimenti scoppierebbe un caos infinito e forse una rivoluzione, facendo saltare l'intero sistema. Perché tutto il sistema di imposizione fiscale italiano si basa su un "non-detto" assurdo, che ha reso tutta la macchina semplicemente folle. Non conviene a nessuno affrontare seriamente il problema, che "tecnicamente" risolvibile è.

Quindi è colpa della AI se non si scovano gli evasori fiscali? La risposta la conoscete già, come e meglio di me.

Ma passiamo alla parte più interessante. Ad un altro tipo di intelligenze artificiali.

Sempre Jeffrey Hinton, nell'intervista citata più sopra, analizzando le limitazioni strutturali e l’orientamento ipercommerciale di molte delle applicazioni di AI di tipo generativo (con nobili eccezioni, come la ricordata AlphaFold) intravvedeva nella fusione fra AI generativa e AI simbolica il vero traguardo della ricerca scientifica.

Questa fusione dovrebbe essere propedeutica al raggiungimento almeno dell’AGI, la chimera del sistema. Che cosa è l’AI simbolica?

In realtà, l’AI simbolica ha rappresentato l’atto di nascita dell’intelligenza artificiale e per anni il suo sviluppo iniziale principale. Le stesse reti neurali, che sono il motore profondo della AI, sono state concepite proprio come replica (simbolica) dei processi cognitivi umani. Perché la mente umana lavora, apprende, e calcola principalmente attraverso simboli.

E questo tipo di AI ha, come aspirazione naturale, proprio quella di replicare il processo cognitivo e deduttivo umano, potenziandolo a dismisura attraverso motori di calcolo che non risentano delle limitazioni (e dei pregiudizi) della nostra mente. Già, perché disgraziatamente tutti i nostri processi mentali, i ragionamenti, anche quelli più astratti e rarefatti, risentono inevitabilmente del nostro stato emotivo, umorale, psichico. Noi non siamo mai “equilibrati” quando pensiamo e ragioniamo, ma pendiamo sempre da qualche parte, senza accorgercene.

Vi faccio un esempio elementare. Quando guardiamo un incontro di calcio, anche se non siamo tifosi di nessuna delle due squadre in campo (e quindi a maggior ragione se lo fossimo) dopo un po’ tendiamo a parteggiare per una delle due squadre. Quando un giocatore della squadra che ci sta più simpatica commette un fallo, siamo propensi a minimizzarlo, a pensare che l’avversario abbia simulato o ingigantito l’impatto del calcio che il nostro favorito gli ha assestato. E viceversa: quando un avversario (o uno sfavorito nella nostra simpatia) commette un fallo, e puta caso l’arbitro non se ne avvede, o gliela fa passare liscia, non sanzionandolo, tendiamo a infuriarci. Anche se i due falli risulterebbero perfettamente uguali.

Per questo motivo hanno inventato un “tertium” in campo, il VAR. Ma molti sostengono che anche il VAR, o meglio i suoi operatori, spesso non restino freddi giudici degli eventi delittuosi in campo.

Per allargare la nostra considerazione ai fondamenti dell’essenza umana, e del nostro vivere sul pianeta, dobbiamo capire che le macchine e gli algoritmi non hanno due o tre problemi che invece costituiscono il cuore della nostra esistenza. Le macchine non muoiono, non fanno all'amore e non hanno fame. E non credono in Dio. Non hanno quindi le paure, i timori, e le gioie, le estasi e i deliri conseguenti. Quando procedono nel calcolo, non sono affette da questi "disturbi". Ma non possono replicare gli abissi dell'animo umano, e i crinali sui quali spesso ci attardiamo per ricevere stimoli per la nostra vita reale, e anche materiale per la nostra infinita creatività (per chi è fortunato a possederla).

Di più, noi possiamo (meglio: potremmo) fare in modo che le connessioni cognitive delle loro conoscenze, collegate da legami sinaptici digitali (ma proprio per questo ci vuole una ripresa degli studi e dei finanziamenti sulle AI simboliche) permangano nel tempo e si accumulino, diventando un patrimonio di conoscenze sinaptiche simil-umane, esterne all'uomo, che permangono nel tempo in modo infinito e possano essere messe a disposizione delle generazioni umane che si succederanno nel futuro.

Se ci pensate, gli umani hanno il brutto vizio di morire, e di annullare con questo ogni loro conoscenza acquisita in anni e anni di studio e di esperienza. Ogni nuovo umano che nasce, per accumulare le stesse conoscenze e competenze, deve ripartire da zero e riacquisire tutto ciò che l’umanità ha capito o scoperto nei secoli, attraverso la frequentazione di scuole. Gli uomini devono acquisire tecniche di pensiero, di calcolo, di ragionamento, di traduzione, e di esperienza (in genere ci si impiega un quarto di secolo) e poi possono iniziare la propria vita adulta nella società.

Un’entità, o più entità, che contengano e possano accumulare progrerssivamente il complesso delle conoscenze umane, di tutti gli umani, potrebbero facilitare di molto la loro educazione e ridurre notevolmente i tempi di apprendimento e di educazione, allargando al contempo enormemente le loro competenze individuali e consentendo a ciascuno di essi di spaziare su svariati campi dello scibile umano con competenza e precisione. Sarebbe uno strumento formidabile per tutta l'umanità, acccessibile — come tutti i cloud — da ogni angolo del mondo.

Ma siccome una tale AI costituirebbe un potenziamento dell’umanità, di ogni singolo essere umano, bianco, nero, giallo o rosso che sia, gli investimenti probabilmente non andranno in questa direzione, ma in quella del mercato imperante. E più si restringe il numero dei decisori di questo sviluppo, più gli algoritmi funzioneranno a detrimento delle masse umane e a vantaggio dei pochi (o pochissimi) che le controlleranno.

Forse ha ragione Hassadib, avremo uno sviluppo economico e commerciale con una nuova età dell’oro, ma a questo corrisponderà probabilmente un impoverimento progressivo ed una marginalizzazione di tutti coloro che, avendo un basso tenore culturale e scolastico, non potranno più aspirare ad un posto attivo in una società piramidale ad altissima componente tecnologica.

Ed il gioco sarà fatto.

Ci sono momenti in cui si raggiungono dei punti di svolta, di non-ritorno, nella storia dello sviluppo umano.

Per questo il depotenziamento della scuola, dell’università e della ricerca scientifica cui stiamo assistendo nelle società occidentali avanzate andrebbe considerato un crimine contro l’umanità.

Un crimine di guerra sociale.

FABRIZIO FUNTÒ

FABRIZIO FUNTÒ